Trong kỷ nguyên công nghệ số, Trí tuệ nhân tạo (AI) và các Mô hình Ngôn ngữ Lớn (LLM) đã trở thành trợ thủ đắc lực trong nhiều lĩnh vực, đặc biệt là lập trình. Khả năng sinh code, gợi ý tự động hoàn thành và debug chương trình của LLM giúp tối ưu hóa quy trình làm việc đáng kể. Tuy nhiên, nhiều công cụ LLM cao cấp thường đi kèm với chi phí đăng ký đắt đỏ và tiềm ẩn rủi ro về quyền riêng tư, khi dữ liệu code nhạy cảm của bạn phải được gửi lên các máy chủ từ xa.

Nếu bạn đang tìm kiếm một giải pháp hiệu quả về chi phí, an toàn dữ liệu và hoàn toàn riêng tư, việc tự host một LLM hỗ trợ lập trình ngay trên máy tính cá nhân là lựa chọn tối ưu. Bài viết này của congnghemoi.net sẽ hướng dẫn bạn từng bước cách thiết lập một môi trường lập trình AI cục bộ trong Visual Studio Code (VS Code) – một trong những IDE phổ biến nhất hiện nay – mà không cần kết nối internet hay lo lắng về việc dữ liệu bị rò rỉ. Quy trình này phù hợp cho cả người mới bắt đầu, sinh viên và các lập trình viên muốn nâng cao hiệu suất làm việc với sự hỗ trợ của AI một cách độc lập.

Tại Sao Nên Tự Host LLM Cho Lập Trình?

LLM đã cách mạng hóa cách chúng ta tiếp cận lập trình. Từ việc tạo ra các đoạn mã phức tạp, giải thích các thuật toán khó, đến việc xác định và sửa lỗi trong code, LLM đều thể hiện sự vượt trội. Tuy nhiên, khi sử dụng các dịch vụ LLM dựa trên đám mây, chúng ta thường đối mặt với hai thách thức chính:

- Chi phí: Đa số các công cụ LLM mạnh mẽ đều yêu cầu gói đăng ký hàng tháng hoặc trả phí theo mức sử dụng, gây tốn kém cho người dùng cá nhân hoặc các dự án nhỏ.

- Quyền riêng tư và bảo mật dữ liệu: Khi bạn cung cấp code hoặc dữ liệu nhạy cảm cho một LLM trên đám mây, thông tin đó sẽ được lưu trữ và xử lý trên các máy chủ từ xa. Điều này có thể gây lo ngại về bảo mật dữ liệu và quyền riêng tư, đặc biệt với các dự án có tính bảo mật cao.

Việc tự host LLM cục bộ khắc phục hoàn toàn những nhược điểm này. Bạn sẽ có một trợ lý AI lập trình miễn phí, hoàn toàn hoạt động offline và đảm bảo rằng tất cả dữ liệu code của bạn được giữ an toàn tuyệt đối trên thiết bị cá nhân.

Chuẩn Bị Trước Khi Bắt Đầu: Yêu Cầu Hệ Thống

Để đảm bảo quá trình cài đặt và vận hành LLM cục bộ diễn ra suôn sẻ, máy tính của bạn nên đáp ứng các yêu cầu tối thiểu sau:

- RAM: Tối thiểu 16GB RAM. LLM tiêu thụ khá nhiều bộ nhớ khi hoạt động.

- Dung lượng lưu trữ: Tối thiểu 10GB dung lượng trống để tải xuống và lưu trữ mô hình LLM.

- Hệ điều hành: Quy trình này tương thích với Windows, macOS và bất kỳ bản phân phối Linux nào.

Cài Đặt Ollama: Nền Tảng Cho LLM Cục Bộ

Ollama là một công cụ mã nguồn mở thân thiện với người dùng, giúp đơn giản hóa việc tải xuống, chạy và quản lý các mô hình ngôn ngữ lớn cục bộ. Đây là bước đầu tiên và quan trọng nhất để đưa LLM về máy tính của bạn.

-

Truy cập trang web chính thức của Ollama tại ollama.com và tải xuống trình cài đặt phù hợp với hệ điều hành của bạn.

-

Thực hiện theo các hướng dẫn trên màn hình để hoàn tất quá trình cài đặt.

-

Sau khi cài đặt xong, mở Command Prompt (trên Windows) hoặc Terminal (trên macOS/Linux) và nhập lệnh sau để khởi động máy chủ Ollama cục bộ:

ollama serve

Lựa Chọn Mô Hình Phù Hợp Cho Lập Trình

Việc lựa chọn mô hình LLM phù hợp là rất quan trọng để có được hiệu quả tốt nhất trong công việc lập trình. Hiện có rất nhiều mô hình chuyên biệt cho việc sinh code. congnghemoi.net khuyến nghị sử dụng Code Llama 7B Instruct vì nó đã được tối ưu hóa tốt cho các tác vụ hỗ trợ code và cho hiệu suất ổn định. Bạn cũng có thể tự nghiên cứu và lựa chọn các mô hình khác dựa trên nhu cầu cụ thể của mình, chỉ cần điều chỉnh lệnh tải xuống tương ứng.

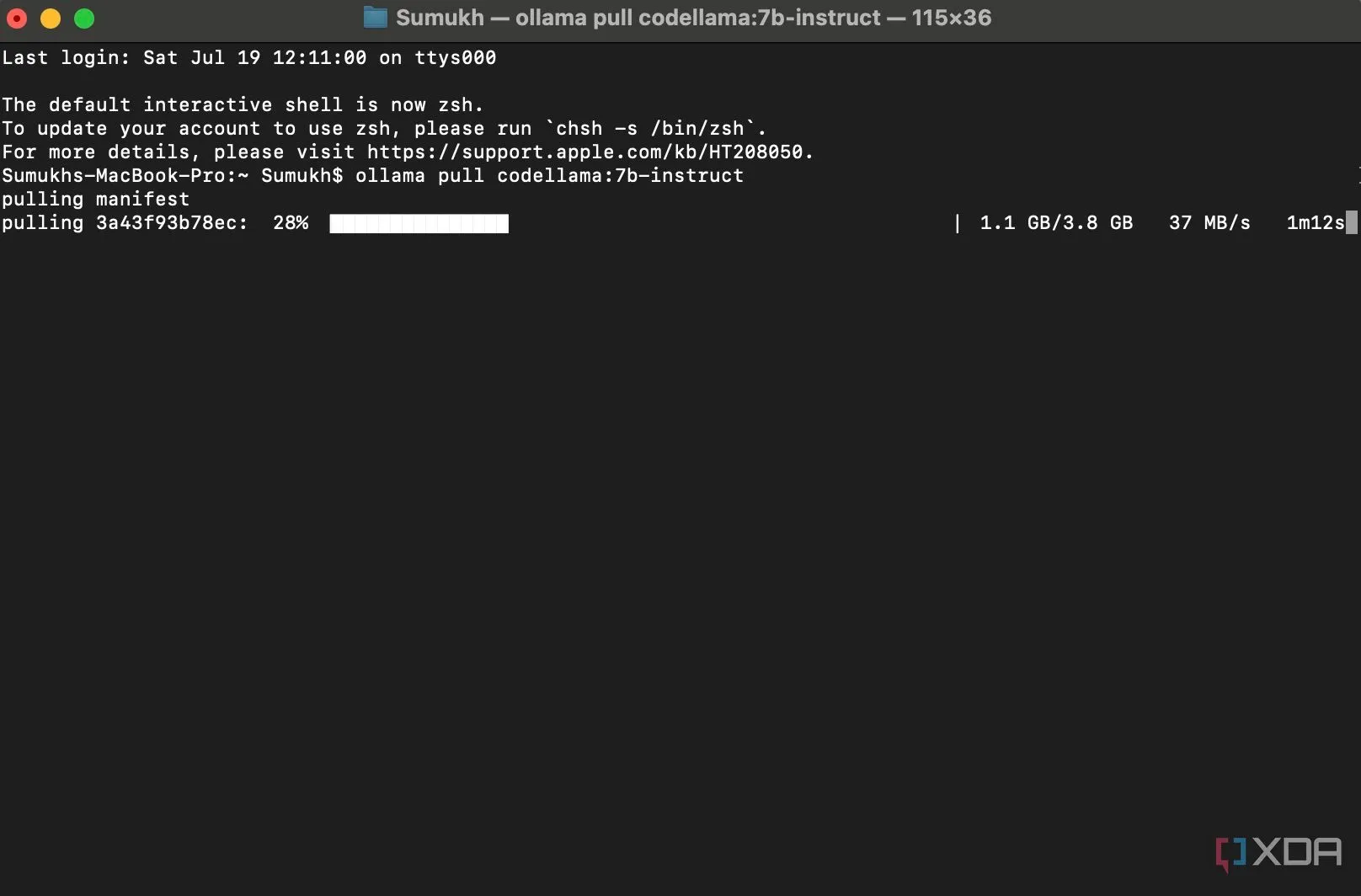

Để tải mô hình Code Llama 7B Instruct, hãy chạy lệnh sau trong cửa sổ Terminal/Command Prompt mà bạn đã khởi động Ollama:

ollama pull codellama:7b-instructHãy kiên nhẫn chờ đợi quá trình tải xuống hoàn tất. Vì mô hình khá lớn và được tải từ internet, thời gian tải sẽ phụ thuộc vào tốc độ và chất lượng kết nối mạng của bạn. Sau khi hoàn tất, chúng ta sẽ chuyển sang tích hợp nó vào VS Code.

Quá trình tải xuống mô hình Code Llama 7B Instruct bằng Ollama trên Terminal

Quá trình tải xuống mô hình Code Llama 7B Instruct bằng Ollama trên Terminal

Tích Hợp LLM Với VS Code Qua Extension Continue

Visual Studio Code (VS Code) là một trình soạn thảo mã nguồn mạnh mẽ và phổ biến, được sử dụng rộng rãi bởi các lập trình viên. Nếu bạn chưa cài đặt, hãy tải xuống tệp cài đặt từ code.visualstudio.com và cài đặt trên máy tính của bạn.

Sau khi đã có VS Code, chúng ta sẽ sử dụng một extension đặc biệt để kết nối và tận dụng khả năng của LLM cục bộ.

Cài Đặt Extension Continue Trong VS Code

Extension Continue giúp VS Code tương tác với các LLM được host cục bộ, biến trình soạn thảo code của bạn thành một trợ lý AI mạnh mẽ.

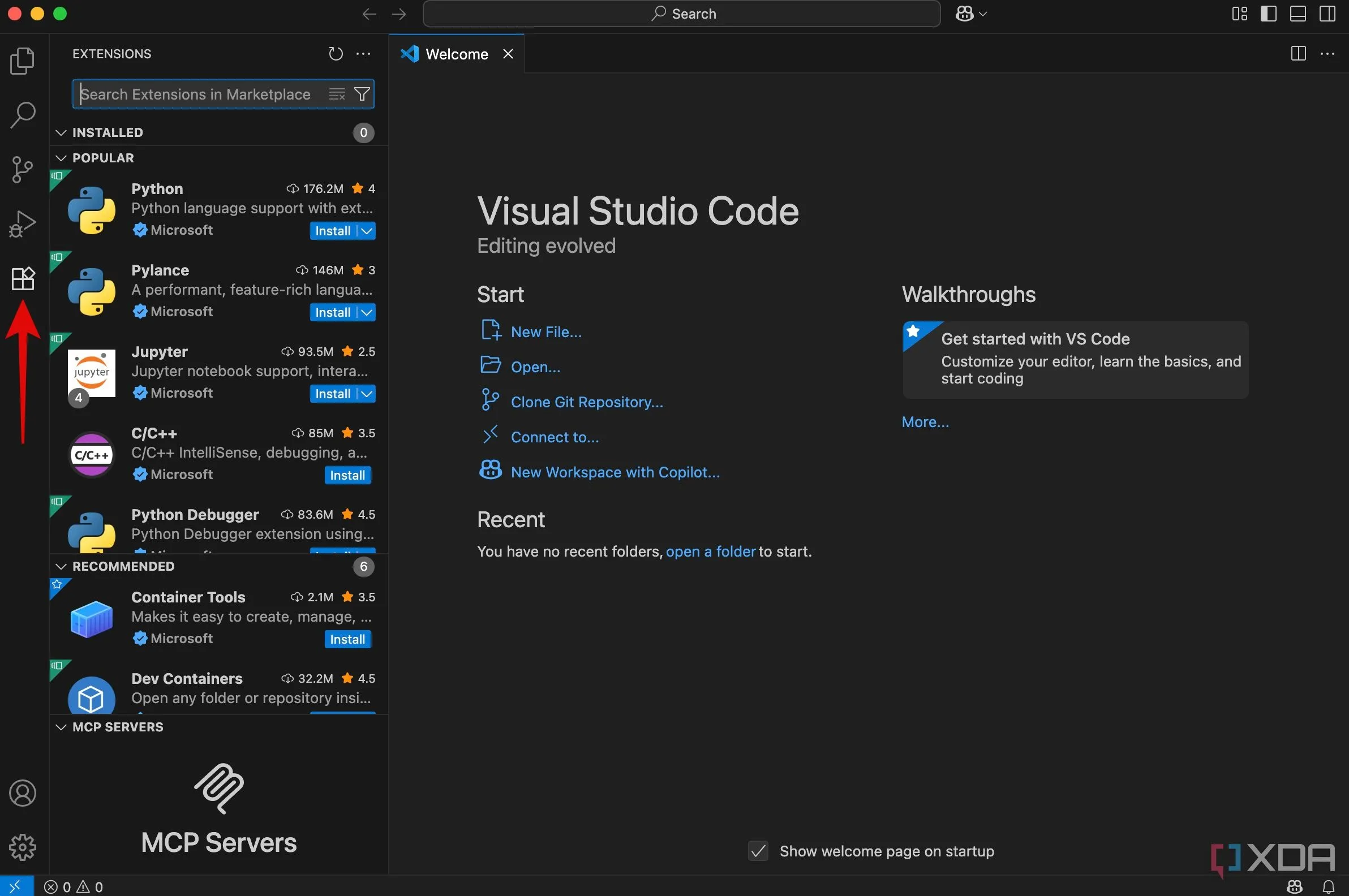

- Mở Visual Studio Code.

- Nhấp vào biểu tượng Extensions (biểu tượng bốn hình vuông) nằm ở thanh bên trái của giao diện.

Giao diện thanh Extensions trong Visual Studio Code để tìm kiếm tiện ích mở rộng

Giao diện thanh Extensions trong Visual Studio Code để tìm kiếm tiện ích mở rộng

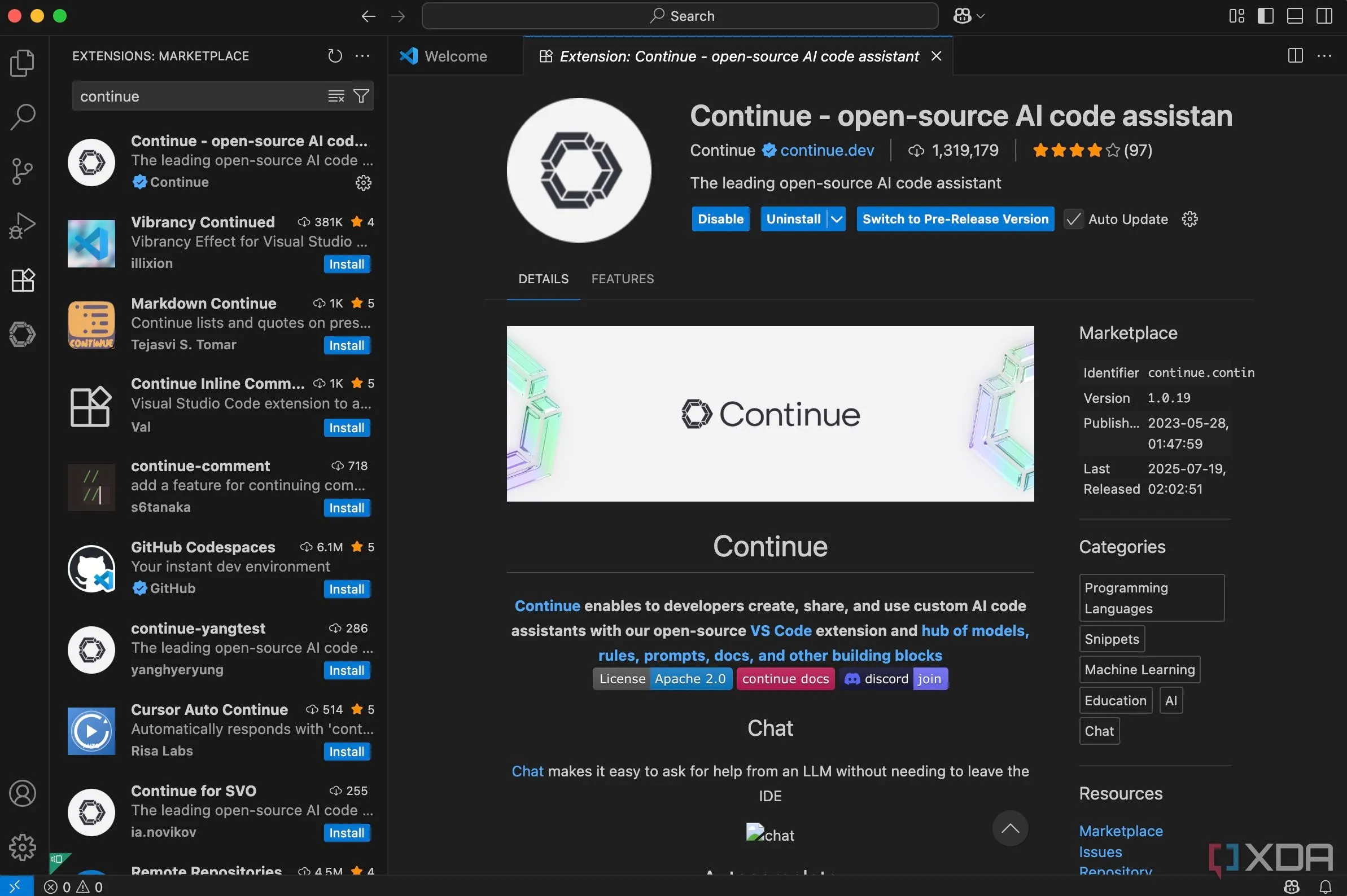

- Trong thanh tìm kiếm Extensions, gõ “Continue” và nhấn Enter.

- Chọn extension “Continue” và nhấp vào nút Install để cài đặt.

Cài đặt extension Continue AI trong Visual Studio Code để tích hợp LLM cục bộ

Cài đặt extension Continue AI trong Visual Studio Code để tích hợp LLM cục bộ

Kết Nối Continue Với Ollama và Mô Hình Đã Tải

Sau khi cài đặt extension Continue, bạn cần cấu hình nó để kết nối với máy chủ Ollama cục bộ và mô hình Code Llama mà bạn đã tải về.

- Chọn biểu tượng Continue mới xuất hiện trên thanh bên trái của VS Code.

- Trong giao diện của Continue, nhấp vào nút Select model.

- Từ menu thả xuống, chọn Add chat model.

- Trong danh sách các nhà cung cấp, chọn Ollama.

- Đối với mục “Model”, chọn CodeLlama Instruct (hoặc bất kỳ mô hình nào khác mà bạn đã tải xuống trước đó).

- Cuối cùng, nhấp vào nút Connect.

- Mở rộng phần Models và chọn codellama:7b-instruct từ menu thả xuống trong tab Autocomplete để kích hoạt tính năng tự động hoàn thành.

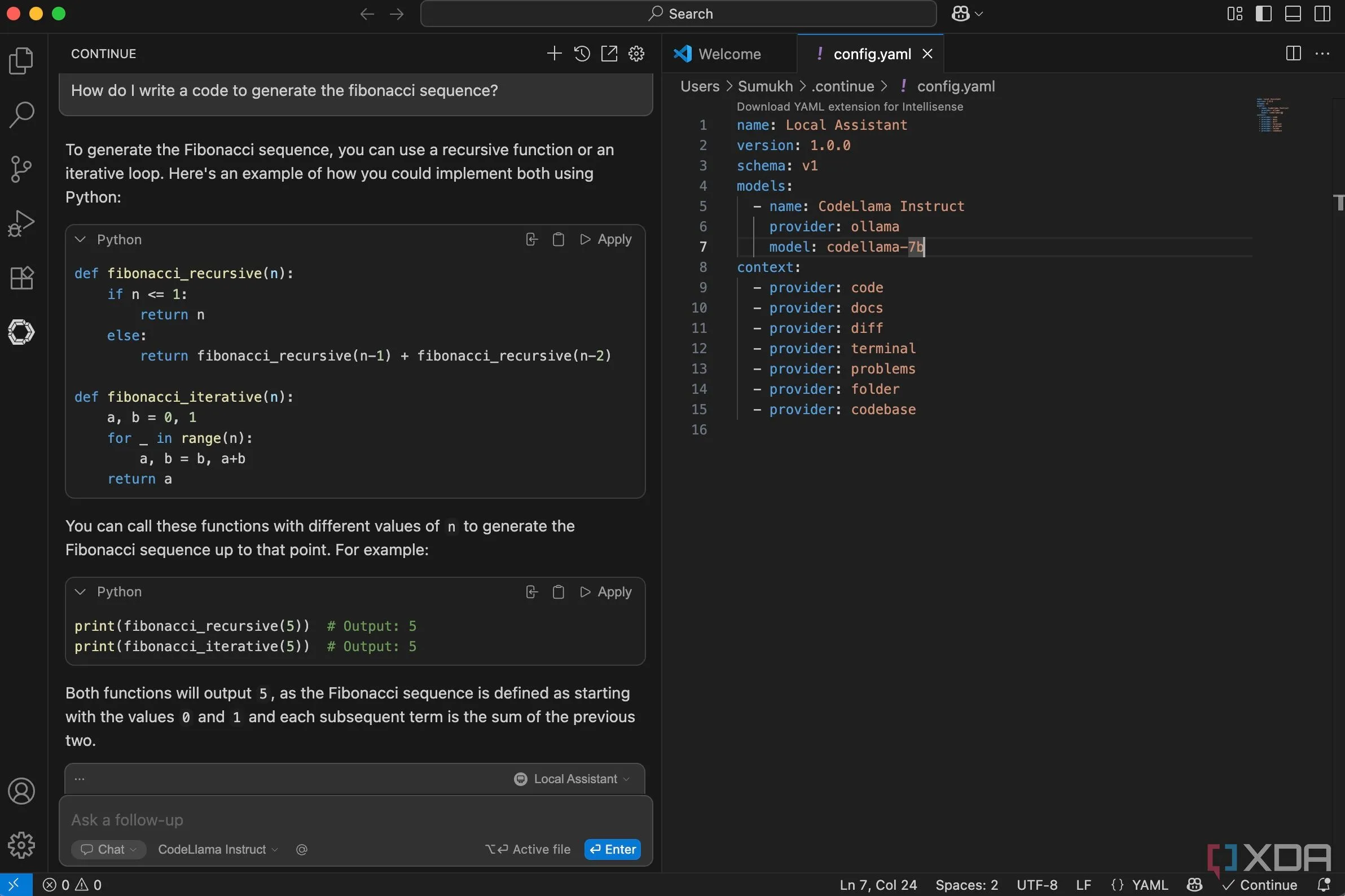

Sử Dụng LLM Để Sinh Code và Tự Động Hoàn Thành

Giờ đây, bạn đã sẵn sàng sử dụng LLM cục bộ của mình để hỗ trợ lập trình!

Bạn có thể sử dụng tab Continue để gõ các câu lệnh bằng ngôn ngữ tự nhiên (prompts) để yêu cầu LLM sinh code, giải thích code hoặc trả lời các câu hỏi liên quan đến lập trình. Ngoài ra, khi bạn bắt đầu gõ code trong trình soạn thảo, LLM sẽ tự động cung cấp các gợi ý hoàn thành mã. Bạn chỉ cần nhấn phím Tab để chấp nhận gợi ý đó.

Sử dụng LLM cục bộ với Continue trong VS Code để tạo và tự động hoàn thành code

Sử dụng LLM cục bộ với Continue trong VS Code để tạo và tự động hoàn thành code

Khi đã quen thuộc với quy trình này, bạn có thể thử tải xuống và cài đặt thêm nhiều mô hình khác từ Ollama để thử nghiệm. Mỗi mô hình có thể có những điểm mạnh riêng, phù hợp hơn với các ngôn ngữ lập trình hoặc loại tác vụ nhất định. Việc nghiên cứu thêm sẽ giúp bạn tìm ra “trợ lý AI” hoàn hảo nhất cho mình.

Kết Luận

Việc tự host một LLM hỗ trợ lập trình cục bộ trên Visual Studio Code thông qua Ollama và extension Continue mở ra một kỷ nguyên mới cho các lập trình viên. Bạn không chỉ có được một công cụ AI mạnh mẽ để sinh code, debug và tăng tốc độ làm việc mà còn được hưởng lợi từ sự riêng tư tuyệt đối và hoàn toàn miễn phí. Mọi dữ liệu code của bạn đều nằm an toàn trên thiết bị cá nhân, không lo ngại bị rò rỉ hay phụ thuộc vào các máy chủ từ xa.

Đối với người mới học lập trình, LLM cục bộ là một công cụ tuyệt vời để khám phá các hàm, cú pháp và cấu trúc chương trình. Còn với các lập trình viên có kinh nghiệm, tính năng tự động hoàn thành và khả năng sinh code sẽ giúp tiết kiệm thời gian đáng kể, cho phép tập trung hơn vào logic và thiết kế hệ thống. Hãy bắt đầu trải nghiệm giải pháp “win-win” này ngay hôm nay và chia sẻ cảm nhận của bạn với congnghemoi.net!